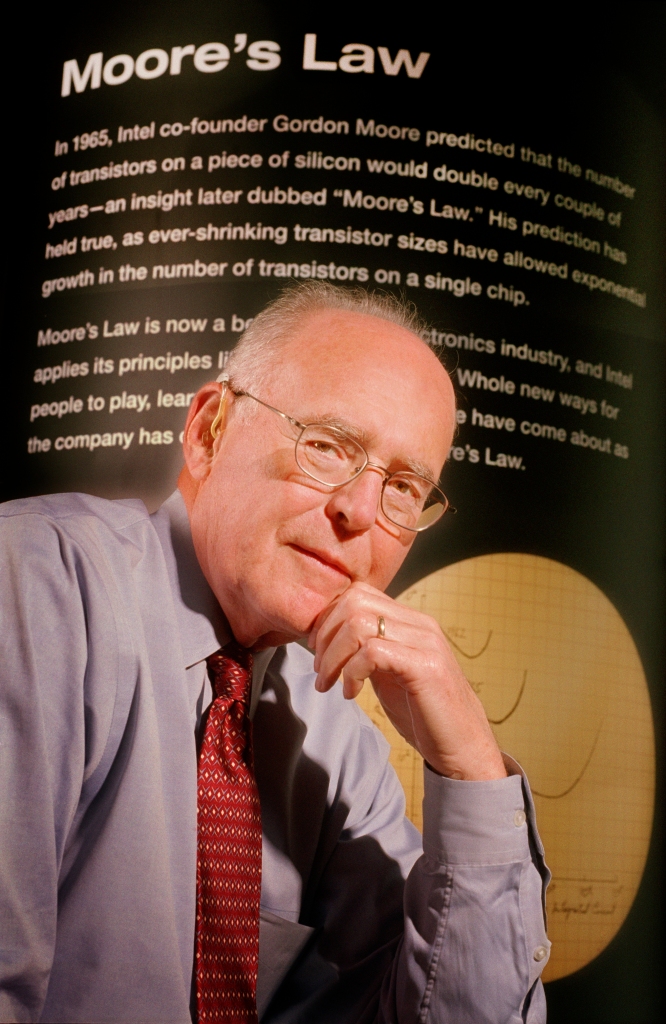

Gordon Moore, der Mitbegründer von Intel, hat im Jahr 1965 in einem in Fachkreisen mittlerweile legendären, weil häufig zitierten, Artikel folgende Beobachtung notiert, nachdem er festgestellt hatte, dass sich die Zahl der Komponenten in einem integrierten Schaltkreis seit deren Erfindung im Jahr 1958 jedes Jahr verdoppelt hatte:

„[…] die Komplexität integrierter Schaltkreise hat sich bei minimalen Komponentenkosten in etwa um einen Faktor von zwei pro Jahr erhöht. […]“.

Zitiert nach Jeremy Rifkin, „Die Null-Grenzkosten-Gesellschaft: Das Internet der Dinge, kollaboratives Gemeingut und der Rückzug des Kapitalismus“, Campus Verlag, Frankfurt am Main, 2014, S. 120

Gordon Moore (* 1929), Mitbegründer der Intel Corp., im Jahr 2005 (Bild (c) Intel Corp.)

Dieses Gesetz, das 1975 dahin gehend angepasst wurde, dass die Verdopplung nur noch alle 2 Jahre stattfindet, hat seitdem (!) Bestand. Anders ausgedrückt: alle 2 Jahre verdoppelt sich die Leistungsfähigkeit von Computern. Wenn man dieses Gesetz auf eine andere Branche, zum Beispiel die Luftfahrt anwendet, dann ergibt sich folgendes Szenario: im Jahr 1978 kostete ein Flug zwischen New York und Paris ungefähr 900 US-$ und dauerte 7 Stunden. Würde das Moore’sche Gesetz hier in gleicher Weise wie in der Halbleiterindustrie gelten, dann läge der Preise für den Flug bereits seit 2005 stabil bei einem US-Cent und würde weniger als eine Sekunde dauern.

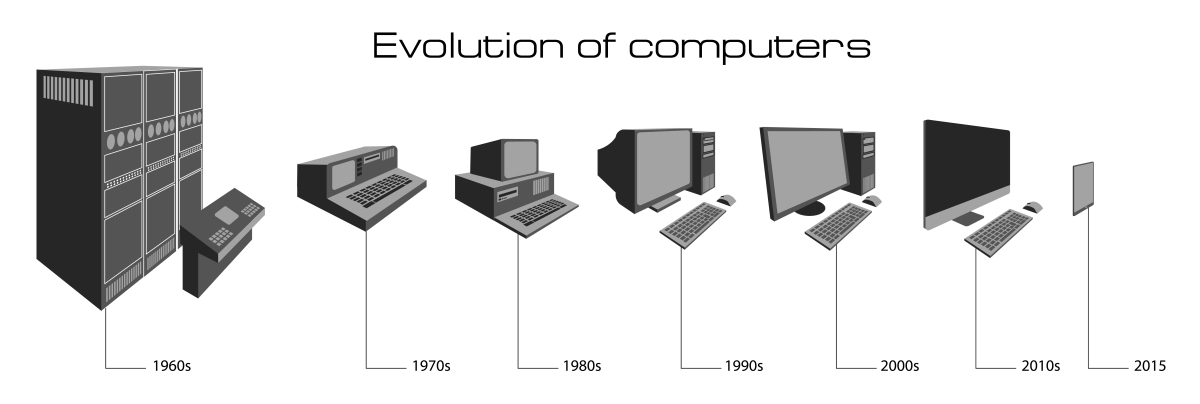

Schauen wir daher an dieser Stelle zunächst einmal darauf, wie sich die Größe von Computern in den letzten 6 Jahrzenten entwickelt hat, um ein Gefühl dafür zu bekommen, wie massiv – ja, exponentiell – sich die Auswirkungen des Moore’schen Gesetzes tatsächlich bemerkbar machen:

- 1950-er Jahre: Computer, die damals noch mit Vakuumröhren statt Transistoren ausgestattet waren, hatten eine für uns heute gigantisch wirkende Größe. Sie füllten ganze Räume mit einem Gewirr von Kabeln, Spulen und Stahl. Natürlich konnte sich so etwas damals nur das Militär leisten.

- 1960-er Jahre: die ersten Transistoren ersetzen Vakuumröhren, die ersten Großrechner erobern allmählich den kommerziellen Markt. Ein Beispiel hierfür ist das IBM System 360, dessen Serie 20 sogar noch mit Lochkarten bedient werden konnte; ein Exemplar davon steht heute noch im Deutschen Museum in München … es hat immer noch die Größe einer kompletten Schrankwand.

- 1970-er Jahre: integrierte Schaltkreise mit inzwischen Hunderten von Transistoren führen zum Bau der ersten Minicomputer … die „nur noch“ so groß wie ein Schreibtisch waren. Die ersten vernetzten Computer in Firmen entstanden Mitte der 70-er Jahre ebenfalls.

- 1980-er Jahre: Mikrochips mit einigen zehn Millionen (!) Transistoren ermöglichten erstmals Personal Computer (PC), die in eine Aktentasche passen. Spielkonsolen wie das Nintendo Entertainment System (NES) werden erstmals kommerzialisiert.

- 1990-er Jahre: Das Internet verbindet viele hundert Millionen Computer zu einem einzigen globalen Netzwerk. Windows veröffentlicht Windows 95, das bis heute gültige Standards erstmalig gesetzt hat. PC’s erreichen allmählich die Größe heutiger Desktops – bei einem Bruchteil der heutigen Kapazität und Leistungsfähigkeit.

- 2000-er Jahre: „Ubiquitous Computing“ löst Chip vom Computer; Chips werden überall in der Umwelt installiert. Im Jahr 2000 führt Sony das erste Mobiltelefon mit einer Kamera ein. Im Jahr 2007 bringt Apple das iPhone auf den Markt, 2010 das iPad, 2015 die Apple Watch.

Die Entwicklung der Computer – immer kleiner, leistungsfähiger und schneller

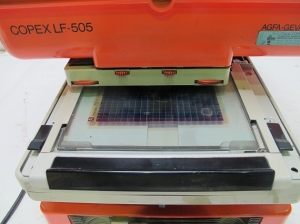

Auch im Apothekenumfeld spiegelt sich die eben beschriebene Entwicklung übrigens interessanter Weise wieder. Beispielsweise gab es hier bis weit in die 90-er Jahre hinein noch die sog. „Lauer-Taxe“ auf Mikrofilm. Diese konnte man auf großen, in grün oder orange gehaltenen Lesegeräten ansehen – also analog – und wahrscheinlich gibt es auch heute noch irgendwo in Deutschland Apotheken, die neben dem Computersystem die Lauer-Taxe nach wie vor auf Mikrofilm beziehen. Doch immerhin schon seit den 80-er Jahren gibt es diese Datenbank, die praktisch die Datengrundlage für die deutsche Apothekenbranche geschaffen hat, in digitaler Form und – natürlich – inzwischen auch online.

Detail eines Mikrofilm-Lesegeräts, Aufnahme von privat

Ähnliches gilt für die Apotheken-Warenwirtschaft. In den späten 80-ern bis in die frühen 90-er waren die Server meist noch größer als die Insulin-Kühlschränke in den Apotheken. Zum Transport mussten mehrere Techniker hart anpacken, um den Server aufzustellen, der aus statischen Gründen oft im den Keller installiert wurde. Inzwischen sind Apotheken-Server kaum größer als Desktops, man kann auch mehrere Server auf einer echten Maschine virtualisieren und diese sogar im Rechenzentrum hosten, also völlig ohne Server-Hardware in der Apotheke.

IBM Server, Model 7013-530, um das Jahr 1990; Bild (c) Museums Victoria / CC BY; direkter Link zum Bild: https://collections.museumvictoria.com.au/items/400545

Konstatieren wir also zusammenfassend, dass Computer immer kompakter, immer leistungsfähiger und zunehmend auch tragbarer werden. Gleichzeitig werden sie immer günstiger (auch eine Auswirkung des Moore’schen Gesetzes) und sind, worauf wir in Teil 2 noch mehr eingehen werden, immer online und vernetzen so die ganze Welt.

Dem Physiker Michio Kaku zufolge, der auch schon einige sehr lesenswerte populärwissenschaftliche Bücher veröffentlicht hat, verlangsamt sich das von Moore postulierte Wachstum allmählich, zumindest im Bereich herkömmlicher Silizium-Technologie. Und auch das Ende des Moore’schen Gesetzes steht für ihn schon fest:

„Um 2020 oder bald danach wird das Moore’sche Gesetz allmählich seine Gültigkeit verlieren und Silicon Valley könnte sich allmählich in einen Rostgürtel verwandeln, es sei denn, man findet eine Ersatztechnologie.

Michio Kaku, „Die Physik der Zukunft. Unser Leben in 100 Jahren“, Rowohlt Verlag, Rheinbek bei Hamburg, 2013, S. 68

Wir werden dann Schaltkreise in der Größenordnung von ca. 5 Nanometern bauen können. Die Unternehmen, deren Wertschöpfung und Wachstum von der regelmäßigen Verdoppelung der Leistungsfähigkeit abhängt, forschen auch tatsächlich bereits an Ersatztechnologien, um auch weiterhin durch schnellere, kleinere und bessere Produkte und Komponenten am Markt bestehen zu können.

Intel beispielsweise forscht an sog. 3-D- oder optischen Chips, die elektronische Datenverarbeitung mit optischen Impulsen in einem Prozessor kombiniert. Andere Firmen beschäftigen sich mit Molekular- oder Quantenrechnern, deren Chips – im Gegensatz zu herkömmlichen Transistoren – nicht nur den Wert 1 oder 0 annehmen können, sondern auch beide oder jeden beliebigen Wert dazwischen; dadurch wird im wahrsten Sinne des Wortes ein Quantensprung bei der Verarbeitungsgeschwindigkeit erwartet und zumindest in der Theorie auch schon bestätigt. Und IBM setzt momentan alles auf ihren Supercomputer Watson, auf den wir aber später ein wenig eingehen werden.

Wie wird er aussehen, der Chip der Zukunft?

Ob und welche dieser Technologien sich langfristig durchsetzen können wird, ist heute noch nicht absehbar. Aber statt darüber zu spekulieren, was sein könnte, wollen wir erst einmal im nächsten Kapitel einen Blick auf die bereits heute existierenden kleinen, äußerst smarten Geräte und deren bereits vorhandenen Möglichkeiten und das enorme, meist noch schlummernde Potential werfen – auch und vor allem für die Gesundheitsbranche.

[…] es ein lokales System mit einer lokalen „ABDA-Datenbank“. Diese enthalten alle, wie bereits in Teil 1, Kapitel 1 am Beispiel der „Lauer-Taxe“ (beide Begriffe werden tatsächlich bisweilen synonym verwendet) […]

LikeLike

[…] – die anderen Gründe liegen v.a. in den immer kleiner werdenden Geräte (über die wir in Teil 1 gesprochen haben) und der zunehmenden Vernetzung von Geräten (Teil […]

LikeLike

[…] den ersten 3 Teilen haben wir die Bausteine der immer kleiner werdenden Geräte, die sich miteinander vernetzen und vor allem mit Daten agieren, intensiv […]

LikeLike

Absolut lesenswert.

LikeLike

Vielen Dank!

LikeGefällt 1 Person

[…] unterstützen und parallel dazu die EDV auf Trab halten. Der Server stand damals im Keller, war so groß wie ein Whirlpool und sorgte für mollige Wärme, selbst im bitterkalten bayerischen […]

LikeLike

[…] Geräte – Computer – werden immer kleiner, immer schneller und besser. Seit dem Jahr 1965 verdoppelt sich die Leistungsfähigkeit von Prozessoren bei gleichbleibenden […]

LikeLike

[…] unterscheiden. Möglich wurde diese Technologie übrigens durch die Digitalisierung, also die immer kleiner und schneller werdenden Geräte in Kombination mit den enormen Mengen an Daten, die vor allem das Internet hervorgebracht […]

LikeLike

[…] bisherige, kurze Geschichte der Digitalisierung ist voller überraschender Wendungen. Firmen, die in ihrem Segment Weltmarktführer waren, wie […]

LikeLike

[…] – das Moore’sche Gesetz lässt grüßen – auch 3D-Drucker werden irgendwann so günstig sein, dass sich jeder […]

LikeLike

[…] nicht wirklich einen PC – aber die Buchhaltung seines Betriebs wird sicherlich mit einem Rechner ihre Rechnungen schreiben. Und der einzelne Arbeiter wird eventuell seine Leistung über einen […]

LikeLike

[…] denen Apotheken in meinem Gedankenexperiment unterlaufen werden, scheinen unausweichlich. Das Moore’sches Gesetz, das seit dem Jahr 1965 wie ein Naturgesetz gilt, hat weiterhin Bestand. Die bisherige rasante […]

LikeLike

[…] so jedenfalls postuliert es das 1965 vom Intel-Mitgründer Gordon Moore aufgestellte sog. Moore’sche Gesetz. Die bisherige Entwicklung bestätigt dieses Gesetz – das natürlich kein Naturgesetz, […]

LikeLike

[…] nur der Anfang? Wenn die Performance der Computer auch weiterhin exponentiell besser wird (das Moore’sche Gesetz lässt grüßen), warum sollten dann in einigen Jahren nicht auch komplexe Rechtsfälle von einer […]

LikeLike

[…] hier nämlich nicht um reine Rechenpower, wie sie besser und schnellere Prozessoren gemäß dem Moore’schen Gesetz regelmäßig hervorbringen. Man braucht, um bei Go überhaupt eine Chance zu haben, Kreativität […]

LikeLike

[…] und ein komplexes mathematisches Verfahren zur Verschlüsselung verwendet wird, ist entsprechende Rechenleistung notwendig. Alle teilnehmenden Rechner müssen stets dieselben, aktuellen Daten besitzen. Einen […]

LikeLike

[…] und -schäden beschrieben, die auftreten, wenn man zu häufig und zu lange aufs Smartphone, Tablet oder auf andere drahtlose Geräte schaut. Dass die Häufigkeit dieser Symptome zunimmt, ist leider […]

LikeLike

[…] dieser Pressemitteilung wurden sie für mich spürbar, die Vorteile der Digitalisierung. Kleine Geräte, die untereinander Informationen – Daten – über klar definierte Parameter austauschen und dann […]

LikeLike

[…] einem meiner allersten Blogbeiträge habe ich über das Moore’sche Gesetz geschrieben, benannt nach Gordon Moore, einem der Mitbegründer von Intel. Im Jahr 1965 hat er in […]

LikeLike

[…] hat, liegt im Speicherplatz der Computer. Dieser war lange Zeit sehr knapp und somit teuer. Trotz Kenntnis des Moore’schen Gesetzes wurde damals noch gespart, wo es nur ging. So auch bei den Jahreszahlen in vielen […]

LikeLike

[…] Männderdomänen. Wer denkt bei Digitalisierung nicht an Namen wie Bill Gates, Steve Jobs oder Gordon Moore? Dabei waren es vor allem Frauen, die an den wichtigsten Meilensteinen der Digitalisierung […]

LikeLike

[…] Hand ruht – und der kleine Finger nach unten abstützt, wegen der Schwerkraft und so. Doch die Telefone wurden immer größer und leistungsfähiger – und immer schwerer. Diese Last bekommt der kleine Finger ab, teilweise mit sichtbaren (aber […]

LikeLike

[…] fünf unterschiedlichen Messeständen, war Telemedizin. Aber nicht auf dem Smartphone oder dem Computer, wie man es auch von hier kennt. Sondern an eigenen Terminals mit großen Bildschirmen, […]

LikeLike

[…] Wachstums“ gar nicht eingetreten sind. Waren also die Vorhersagen, die damals mit Hilfe von Computern an Großrechnern ermittelt wurden, […]

LikeLike